【お知らせ】がんばる企業応援マガジン最新記事のご紹介

1. 身近になったAIの進化と特徴

ここ1~2年で、AI(人工知能)が急速に身近になった。一般的には、AI画像生成アプリが大幅に増えたことを実感しているのではないだろうか。これらの画像アプリは、これまでの画像の明るさや色味を変えることだけでなく、画像そのものを生成できることが特徴だ。ペンで簡単な線を引いただけ、あるいはキーワードから芸術家のような作品に仕上げることができる。

AIには学習が必要だが、学習データがある程度用意されたAIが多く登場した。これにより、キーワードや簡単な線から画像の生成を可能となり、さらにキーワードを加えていくことで画像をチューニングできる。特定の画家のデータを大量に読み込ませることで、その特徴を備えた作風の画像を作成することも可能だ。

その効果はすさまじく、例えば画像投稿サイト「pixiv」では、AIにより学習させ生成した画像の投稿を原則禁止にしている。学習の対象となった画家が不利益を被る可能性があるためだ。学習させたAIは、短時間で何百も画像を生成できるため、なりすましなどに対する処置といえる。

他の多くの分野でもAIが活躍している。例えば、AIを活用した文字起こしサービスに会議の録音データをアップロードすれば、発言者別に会話をテキストに変換でき、議事録係が会話をメモしなくても議事録を作成できる。現状でも録音状況に気をつけ、マイクの場所やノイズに注意して録音すれば十分な品質のテキストが得られる。

このようなことが可能になったのは、AIの進化にある。第一世代と呼ばれるAIは人間がルールを作成し、そのルールに従って推論や探索を行っていた。第二世代になると機械学習(マシンラーニング)が取り入れられ、サンプルとなるデータと特徴量をもとにAIがルールや知識を学習し、自動的に判断し答えを出すものに少し進化した。

第三世代になると、深層学習(ディープラーニング)が登場する。深層学習は人間の脳の再現を試みるもので、機械学習のようにデータや特徴量を人間が与えなくても、膨大なデータを読み解いて自らルールや相関関係などの特徴を見つけ出す。そして自己学習を続けて自ら精度を高めていく。

これら三つの世代のAIは置き換わってきたわけではなく、それぞれが進化を続けている。そして、必要に応じて組み合わされて活用されている。さらにクラウドやモバイルアプリなどITの進化が合わさり、用途は限定されているが「AIの民主化」の時代に入ったといえるだろう。

AIの世代と特徴

目次へ戻る

2. 生成AIのリスクとサイバーセキュリティへの影響

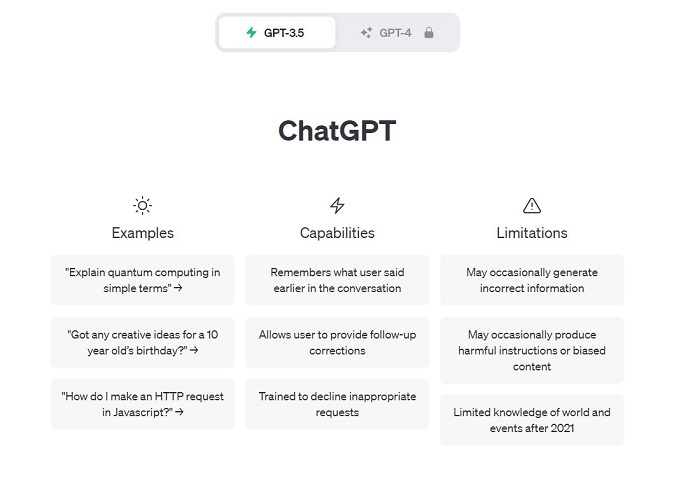

OpenAIが2022年11月に発表した「ChatGPT」は、チャットボットとして登場した。OpenAIによってトレーニングされた大型の言語モデルが背景にあり、人工知能によって文章情報を学習し、自然言語を用いてコミュニケーションできることが特徴である。つまり、Webサイトやアプリ(提供開始予定)に自然文で質問することで、さまざまな形で回答を得られ、会話を続けていくことができる。

ただし、ChatGPTが学習の対象としているのは2021年までの数年間であり、それ以降の期間のことには原則答えられない。検索の代わりにChatGPTを使うケースも見受けられるが、その回答の正確性や最新性は期待できない。一方、「生成AI」と呼ばれるように、長い文章を要約したり、絵を描いたり、楽曲を作ったり、プログラムを記述することさえできてしまう。

この生成AIというChatGPTの特徴が、大きな問題となっている。例えば、ChatGPTの登場後、大学の論文をChatGPTに書かせたり、学校の宿題をやらせたりするケースが増加した。複雑な数式も解けるし、言語翻訳も得意であるためだ。企業が顧客サポートのチャットボットなどの業務に活用する一方で、カンニング的な使い方もされているのが現状だ。そのため、生成AIの利用を禁止する学校も少なくない。

また、ChatGPTはトレーニングデータに基づいて応答を生成するため、不適切なデータやバイアスのあるデータが入力されると、不正確な応答を生成する可能性がある。さらに、ChatGPTの応答を利用して、プライバシーやセキュリティに関連する情報を盗み取ることができる場合もあると考えられる。

サイバーセキュリティにおいても、AIをだます手法は以前から存在する。例えば、画像のデータに手を加える手法がある。そうすると、人の目では普通の画像であっても、AIは全く別のものと判断してしまう。人の目では判断できないところがポイントといえる。

ChatGPTも、悪意を持った者に悪用されるリスクがある。自然文の作成が得意であり、翻訳も可能なため、フィッシングに用いられる可能性もある。また、悪意のあるチャットボットを作成され、詐欺に利用されるリスクもある。フェイクニュースの作成も考えられる。

ソーシャルエンジニアリングだけでなく、ChatGPTはプログラミングも可能なため、マルウェアや脆弱性を悪用する攻撃コードを作成される可能性もある。もちろん、OpenAIでそうした悪用ができないように保護している。しかし、サイバー犯罪者の地下市場では、そうした規制を回避するプラグインが販売されているという情報もある。

これが事実であれば、高度なフィッシング攻撃やマルウェア攻撃、あるいはフェイクニュースの作成などが誰でもできてしまう。それはサイバー攻撃全体の増加と高度化を招く恐れがある。生成AIはこうしたリスクをはらんでいるため、利用には正しい知識と意識が必要となるのだ。

「ChatGPT」は、ユーザー登録によりバージョン3.5を無償で利用できる(https://chat.openai.com/)

目次へ戻る

3. 企業がよりよく生成AIを活用するポイント

ChatGPTは、マイクロソフトがWebブラウザー「Edge」の検索エンジン「Bing」や、Windows 11に採用している。グーグルも「Chrome」の検索エンジンにChatGPTの応答を追加するブラウザーエクステンションを発表しており、ChatGPTの採用が拡大している。また、Meta(旧フェイスブック)は独自の生成AI「Llama 2」を発表し、提供を開始している。

ChatGPTを活用したサービスも多くの企業から提供されており、さまざまな業種・業界で利用されている。しかし、前述のように生成AIの活用にはリスクがつきまとう。現在、文部科学省が「『初等中等教育段階における生成AIの利用に関する暫定的なガイドライン』の作成について」を、JDLA(日本ディープラーニング協会)が「生成AIの利用ガイドライン」を、それぞれ公開している。

自社で生成AIの利用を始める際には、こうしたガイドラインを参考に自社のルールを策定しておくべきであろう。例えば、JDLAのガイドラインでは、「OpenAI社は外国の第三者であるため、個人情報保護法上、個人データの入力はできない可能性が高い」との記述がある。こうしたことを意識した上で、安全に利用したい。

また、生成AIは「ある単語の次に用いられる可能性が確率的に最も高い単語」を出力することで、もっともらしい文章を作成していく。このため、書かれている内容には虚偽が含まれている可能性がある。生成AIのこのような限界を知り、その生成物の内容を盲信せず、必ず根拠や裏付けを自ら確認することが重要となる。

生成AIの利用では、学習においては既存の著作物の使用が可能であるが、生成物の複製・配信などを行う際には著作権侵害行為に該当する可能性もある。特に、特定の作者や作家の作品のみを学習させた場合はこの可能性が高いので注意が必要だ。商標権・意匠権侵害についても同様である。

ChatGPTは、AIの可能性を分かりやすく示した。さまざまな作業がAIによって短時間で行えるようになり、自動化が可能になっていく。「AIに仕事を奪われる」ことも一時期話題になったが、生成AIにおいてはチューニングが重要になるため人間は必要であるし、作業を自動化することで他のより良い業務を進めていくことができる。まずは試験的に一部の業務から導入してみることも有効であろう。

目次へ戻る

ChatGPTのビジネス活用の基礎を無料で学べます【ビジネスeラーニング】

ChatGPTビジネス研修

大塚IDをお持ちの方であればどなたでも無料で受講いただけるビジネスeラーニングに、ChatGPTの基礎知識を学習できる動画教材をご用意しました。

活用事例やリスクなど、ビジネス活用に必要な知識を習得することができる、すべてのビジネスパーソンに受講いただきたいコースです。

【お知らせ】がんばる企業応援マガジン最新記事のご紹介

この記事を社内で共有し、課題解決のヒントにお役立てください

お客様マイページの「連絡ボード」機能を使って、同じ会社のメンバーと簡単にこのページを共有できます。社内で情報を共有し、組織全体の課題解決や業務効率の向上にお役立てください。

社内のメンバーに共有する(企業で共有する)

- (注)連絡ボードを利用するには企業設定が必要です。