【お知らせ】がんばる企業応援マガジン最新記事のご紹介

1. 容易に手が届くパソコンをサーバーに転用

かつて企業の基幹業務システムといえば、メインフレームでCOBOLのプログラムを稼働させるのが定番でした。メインフレームのアーキテクチャはベンダー独自のものです。ベンダーが変わるとプロセッサーもOSも、データベースなどのソフトウェアも何もかも変わってしまうものでした。

その状況を変えたのが「オープン化」の流れであり、オープン化によって登場したのがUNIXサーバーです。プロセッサーなどのハードウェアも、OSもベンダー独自のものでしたが、OSはどれもUNIXの一種で、その上で動作するソフトウェアにはある程度の互換性がありました。

日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏(写真1)は、オープン化によって最も変わった点としてデータベースを挙げます。「どのUNIXサーバーでもOracle Databaseが動作した。業務アプリケーションはOracle Databaseと、Javaで記述したプログラムに変わっていった」と語ります。

(写真1)日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏 *内容は取材当時のもの(写真:加山恵美)

90年代後半からはいよいよ「PCサーバー」が普及してきます。インテルのプロセッサーとその互換プロセッサーを使っていることから「IA(Intel Architecture)サーバー」や「x86サーバー」と呼ぶこともありますね。

ちなみに、世界初のPCサーバーはCompaq Computer(当時:後にHewlett-Packardが買収)が1989年11月に発売した「Compaq SystemPro」(写真2)。プロセッサーは33MHz駆動のIntel386です。後にオプションとして33MHz駆動のIntel486を載せた拡張ボードが登場しました。この拡張ボードを取り付けることで、Intel386とIntel486の両方を利用できるという、少し変わった作りのサーバーでした。しかしPCサーバーの本格的な普及は、Windowsが普及する90年代後半まで待たなければなりません。

(写真2)世界初のPCサーバー「Compaq SystemPro」

Windowsが本格的に普及し始めたのは、パソコンの性能向上のペースが上がり始めた頃です。性能が上がったので、サーバーに転用するという発想がようやく出てきたのでしょう。しかし、パソコンとサーバーは設計がまるで違います。例えば、パソコンはサーバーのように24時間動き続けることを想定した作りにはなっていません。そこで連続稼働に耐えられるように耐久性のあるハードディスクを搭載したり、電源を二重化したりするなどの改良を加えて、信頼性を強化してサーバーとして稼働できるようにしたのです。

ハードウェアが登場した流れとしてはメインフレーム、UNIX、PCサーバーの順ですが、山中氏は反対の方向から経験したそうです。山中氏はこう述懐します。「新人時代は疑問でした。PCを使っていた身からすると、UNIXワークステーションを基にしたUNIXサーバーと、PCを基にしたPCサーバーには大して違いがないように思えました。しかし実際に使ってみるとUNIXサーバーとPCサーバーは全くの別物でした」

PCサーバーが普及し始めた頃はファイルサーバー、プリントサーバーのほか、グループウェアや会計のアプリケーションサーバーなど、企業の部門レベルで利用するケースが多くありました。性能の良いパソコンをサーバーとして使うため、見た目はデスクトップ型やタワー型など、パソコンそのままでした。

今考えると驚きですが、サーバーなのに設置場所はサーバールームではなく、オフィスの片隅ということもしばしばでした。終業時に担当者が電源を落として帰ることも。山中氏は「オフィスで稼働するので『ファンがうるさい』と言われてしまったりね」と苦笑い。

PCサーバー普及を後押しした要因として山中氏はMicrosoftのサーバーソフトウェア群を挙げます。Microsoft Windows Server(IISも含めて)にMicrosoft SQL Server、Microsoft Exchange Server。WindowsのGUIで操作できるので、サーバー導入の敷居を下げました。山中氏は「Compaq ProLiant DL 760が出た頃は、Windowsで何でもできるということで、いろんなアプリケーションを稼働させるデモをしました」と述懐します。

目次へ戻る

2. 消費電力と管理工数という課題と向き合いながら

日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏(写真3)は「Opteronプロセッサーは一つの転機でした」と振り返ります。プロセッサーが性能を向上させながら消費電力も増加させていた頃、AMD(Advanced Micro Devices)が発売したサーバー向けプロセッサーが「Opteron」です。

(写真3)日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏 *内容は取材当時のもの(写真:加山恵美)

Opteronはインテル互換のアーキテクチャで64ビットと32ビットの両方のプログラムが動くプロセッサーという大きな特徴がありますが、消費電力を抑えたプロセッサーであることも見逃せない特徴でした。プロセッサーの消費電力が低いため、データセンターで使えば顕著な節電につながるとして注目を集めました。「Opteronの登場は、プロセッサーで消費電力を抑えようという動きにつながりました。サーバーの消費電力を考える転機になったと思います」(山中氏)

PCサーバーの消費電力量が上がっていくと、サーバーの置き場所も変わっていきました。前回述べたように、PCサーバーが普及し始めた頃は、オフィスに設置するケースが多くありました。しかしPCサーバーの性能向上とともに消費電力も上がり、200V電源を必要とするサーバーも登場しました。一般的なオフィスには100V電源しかありませんので、特別に200V電源を引き込んだ部屋(サーバールーム)を用意して、そこに置くようになっていきました。さらにサーバーの台数が増えていくと、サーバーはオフィスから離れて、データセンターに預けて運用するようになります。

サーバーの台数が増えると、もう一つの課題である管理工数が大きな問題としてのしかかってきます。よく指摘されることですが、ITシステムの導入から運用、廃棄までにかかる費用を見ると、新規導入コストが占める割合は意外に低いものです。新規導入よりも、保守や維持管理により多くのコストがかかるのが普通であり、このコストも消費電力と同様に増加の一途をたどっています。さまざまな工夫で抑制する動きはありますが、管理台数の増加や多様化もありトータルではなかなか減らせていません。

PCサーバーは当初デスクトップPCに似たタワー型が主流でした。しかし2000年を過ぎたころからラックマウントサーバーが増えてきました。厚さがわずか1U(44.45mm)の薄型ラックマウントサーバーが登場したのもこの時期です(写真4)。ほかにもキューブ型などの省スペースサーバーも登場しましたが、最終的にPCサーバーの主流はブレード型やラックマウント型で落ち着きます。

(写真4)2000年代になると、厚さが5cmにも満たない薄型ラックマウントサーバーが登場する。写真はCompaq Computer(当時)が2001年9月に発売した「ProLiant DL360」。世界初の1Uラックマウントサーバーとなった製品だ

ブレード型サーバーは、部品交換などの保守管理を容易にし、ケーブル配線や冷却の効率も上げてくれます。管理工数を抑えるだけでなく、電力消費はじめトータルの維持費の抑制につながります。オフィスのサーバーはホスティングサービスを利用して外部に設置されるようになり、集中管理されていきます。

サーバーの設置場所がデータセンターへと向かう過程では、ネットワーク通信速度の向上とリモート管理ツールの充実が進みました。どちらもサーバーをオフィスの外に設置するなら欠かせない要素です。

目次へ戻る

3. PCアーキテクチャを超えて、「メモリードリブンコンピューティング」へ

PCサーバーの歴史を振り返ると、Compaq Computerが世界初のPCサーバーを発売し、普及に力を尽くしてきたことが分かります。そのCompaq Computerは他企業を買収して、その技術をPCサーバー開発に生かしています。1997年には無停止サーバー「NonStop」シリーズを開発販売していたTandem Computersを買収しました。サーバー間インターコネクトとして普及している「InfiniBand」の源流には、同社の技術があります。

そして、翌1998年には「Alphaプロセッサー」などの技術を持つDEC(Digital Equipment Corporation)を買収します。そして、そのCompaq Computer自体を2002年に買収したのがHewlett-Packardです。

日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏(写真5)は、DECの技術についてこう話します。「DECにはAlphaプロセッサーを中心とする『Alphaアーキテクチャ』がありました。信号回り、チップセット周辺のデザインが優れていたのです。その技術は今でもHewlett-Packard製品のバスやインターフェイスに生かされているんですよ」

(写真5)日本ヒューレット・パッカード データセンター・ハイブリッドクラウド事業統括 DCHC製品統括本部 エバンジェリストの山中伸吾氏 *内容は取材当時のもの(写真:加山恵美)

ところで、サーバーで性能を向上させる手法にはスケールアップとスケールアウトがあります。前者は単体のサーバーの性能をどんどん高めていく手法、後者はサーバーの台数を増やして、分散処理で全体の性能を高める手法です。スケールアウトでは、1Uサイズのラックマウントサーバーなど、小規模のサーバーを大量に使う場合が多くあります。

一方、スケールアップで性能を高めていった高性能なサーバーにもPCサーバーの系統が出てきています。例えばHewlett-Packardは、ミッションクリティカルな用途に向けた高性能サーバー製品群「Superdomeシリーズ」を持っています。かつてはHewlett-Packardが独自開発した「PA-RISCプロセッサー」や、Hewlett-PackardとIntelの共同開発で生まれた「Itaniumプロセッサー」を採用したものしかありませんでした。どちらのプロセッサーも、設計の段階からミッションクリティカルな用途で使用することを想定したものです。

そのSuperdomeシリーズにも、パソコンが搭載するx86(x64)プロセッサーを搭載したものが登場します。それが2014年発表の「Superdome X」です。パソコンの転用からスタートしたPCサーバーの系譜が、Superdomeのような高性能サーバーにまで到達したと考えると、感慨深いものがありますね。

では、これから先はどうなるのでしょうか。山中氏は「もうスケールアウトもスケールアップも垣根がなくなりますよ。インターコネクトが高速化すれば同じです」と言います。

現状のコンピューターはプロセッサーが中心となり、それにメモリーがつながる形になっています。多数のサーバーでクラスターを作ると、サーバー同士の通信速度がボトルネックになりますが、山中氏によると将来は光通信を利用した高速インターコネクトでプロセッサーとメモリー、そして隣り合うサーバーのプロセッサーをつなげるようになると言います。インターコネクトが光通信になると、消費電力も現在と比較して1/400ほどになるなど、省電力化にも大きく寄与すると期待されています。ただし、実現するにはプロセッサーが光インターコネクトに対応するなどの課題をクリアしていく必要があります。

さらに山中氏はサーバーのアーキテクチャが大きく変わると言います。「現在、記憶装置としてメモリーとハードディスクを併用するのは、電源を切るとメモリー上のデータが消えてしまうからです。電源を切ってもデータが消えない不揮発性メモリーを、現在のメモリーと同程度のアクセス速度で使えればどうなるでしょう? ハードディスクが不要になります」と将来像を語ります。

現在も、大量のメモリーを搭載して、大量のデータを全てメモリーに置いて「インメモリー処理」をするソフトウェアが存在します。好例がSAPのHANAです。そのインメモリー処理でも、ハードディスクあるいはNANDフラッシュなどの不揮発性メモリーを「2次記憶装置」として使います。電源が切れてもデータが消えないことを保証するためです。山中氏が語る将来像は、高速にアクセスできる不揮発性メモリーを利用したインメモリー処理とも呼べるものです。

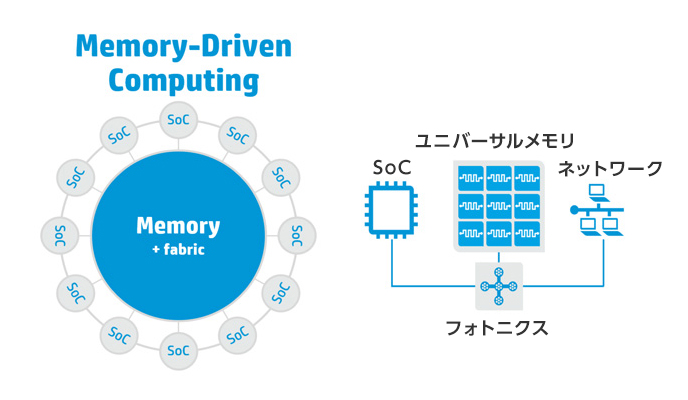

さらに山中氏は、現在のプロセッサーにメモリーが付属するアーキテクチャから、「一つの大容量高速不揮発性メモリーに多数のプロセッサーが光インターコネクトでつながるアーキテクチャになっていく」という未来像を描いて見せてくれました。Hewlett-Packardは、このアーキテクチャを「メモリードリブンコンピューティング」と呼んでいます(写真6)。中央に位置する大容量高速不揮発性メモリーにつながるのはCPUとして利用しているプロセッサーだけではありません、信号処理を得意とするDSP(Digital Signal Processor)、3次元グラフィクス処理やディープラーニングを得意とするGPU(Graphics Processing Unit)、多様な機能を組み込んだSoC(System on Chip)など、さまざまなアーキテクチャのプロセッサーがつながり、高速にデータを処理していくようになるとのことです。

(写真6)メモリードリブンコンピューティングでは、大容量高速不揮発性メモリーが中心となり、そこに多様なプロセッサーがつながる(出典:日本ヒューレット・パッカード)

この構想を実現するには、現在メモリーとして利用しているDRAM(Dynamic Random Access Memory)と同程度の速度でアクセスできて、安価に大量生産できる不揮発性メモリーが必要です。Hewlett-Packardはその候補の一つとして「メモリスタ」と呼ぶ、全く新しい構造のメモリーについて研究しています。

光インターコネクトも、メモリードリブンコンピューティングも、メモリスタも2014年にHewlett-Packardが発表した「The Machine」と呼ぶ次世代コンピューティングアーキテクチャにつながる話です。現段階では構想を発表したところで、2020年までの商品化を目指して開発中です。果たして東京オリンピックが始まるまでに、サーバーアーキテクチャの大変革は起こるのでしょうか? 楽しみな話ですね。

目次へ戻る

【お知らせ】がんばる企業応援マガジン最新記事のご紹介

この記事を社内で共有し、課題解決のヒントにお役立てください

お客様マイページの「連絡ボード」機能を使って、同じ会社のメンバーと簡単にこのページを共有できます。社内で情報を共有し、組織全体の課題解決や業務効率の向上にお役立てください。

社内のメンバーに共有する(企業で共有する)

- (注)連絡ボードを利用するには企業設定が必要です。